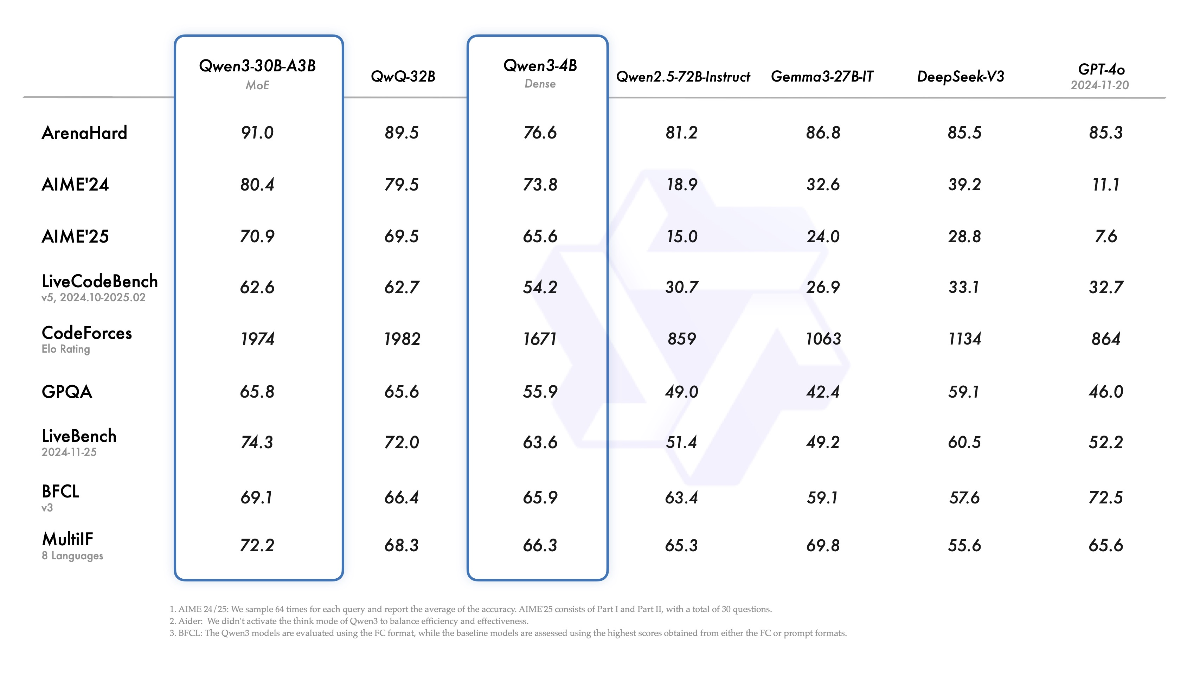

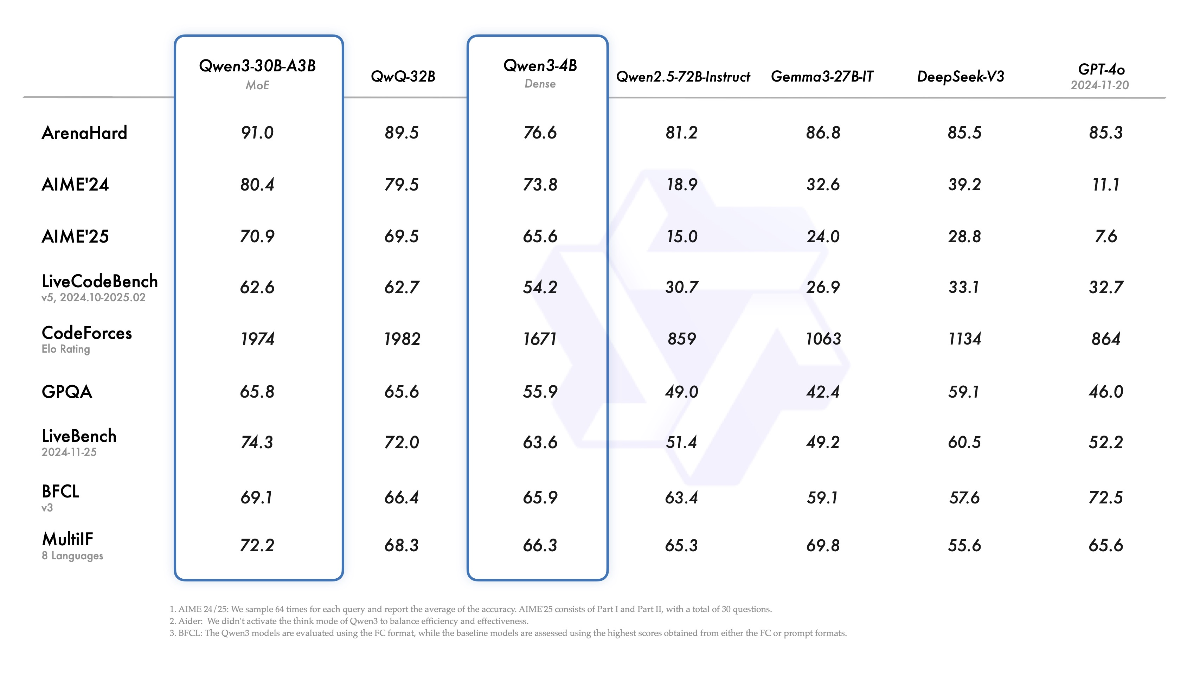

模型性能对比

Qwen3 系列模型在各种基准测试中表现出色,以下是与其他顶级模型的性能对比

轻松部署最新的 Qwen3 大型语言模型,从 0.6B 到 235B 全系列支持,无需复杂配置,一键启动您的 AI 应用

通义千问 Qwen3 系列包含 2 个 MoE 模型和 6 个密集模型,规模从 0.6B 到 235B,性能卓越,本地部署便捷

Qwen3-235B-A22B 在编码、数学和通用能力等基准测试中与 DeepSeek-R1、o1、Grok-3 等顶尖模型相比,取得了具有竞争力的结果

小型 MoE 模型 Qwen3-30B-A3B 在激活参数量仅为 QwQ-32B 的十分之一的情况下,性能超越了 QwQ-32B

微小模型 Qwen3-4B 能媲美 Qwen2.5-72B-Instruct 的性能,为资源受限环境提供高质量选择

FlashAI 整合包提供简单的安装流程,无需复杂配置,几分钟内即可在本地运行 Qwen3 大模型

本地部署确保您的数据不会离开您的设备,为敏感应用场景提供安全可靠的解决方案

支持多种模型参数调整,可根据您的硬件配置和应用需求进行优化,实现最佳性能

Qwen3 系列模型在各种基准测试中表现出色,以下是与其他顶级模型的性能对比

只需简单几步,即可在本地运行强大的 Qwen3 大模型

从我们的官方网站下载 FlashAI Qwen3 整合包,支持 Windows、macOS 和 Linux 系统

解压下载的文件,双击运行安装程序,按照向导完成安装

安装完成后,启动 FlashAI 应用,模型将自动加载,您可以立即开始使用

不同规模的 Qwen3 模型对硬件有不同的要求,以下是推荐配置

看看其他用户使用 FlashAI Qwen3 整合包的体验

数据科学家 | 北京

"作为一名数据科学家,我一直在寻找能在本地运行的高质量大语言模型。FlashAI 的 Qwen3 整合包让我惊喜,安装过程极其简单,模型性能令人印象深刻,特别是在处理中文内容方面表现出色。"

软件工程师 | 上海

"我们团队需要一个能在离线环境中运行的 AI 模型用于代码生成和审查。FlashAI 的整合包完美满足了我们的需求,Qwen3-7B 模型在我的 RTX 3080 上运行流畅,代码生成质量非常高,大大提升了我们的开发效率。"

研究员 | 深圳

"我们研究所需要处理大量敏感数据,不能使用云端 AI 服务。FlashAI 的 Qwen3 整合包让我们能够在本地服务器上部署强大的 AI 模型,安装过程简单明了,模型性能出色,特别是在处理专业领域知识方面表现优异。"

关于 FlashAI Qwen3 整合包的常见问题解答

FlashAI Qwen3 整合包支持 Windows 10/11 64位、macOS 10.15 及以上版本(包括 Intel 和 Apple Silicon 芯片)以及主流 Linux 发行版(Ubuntu 20.04+、CentOS 7+、Debian 10+)。

对于配置较低的电脑,我们建议使用 Qwen3-0.6B 或 Qwen3-1.5B 模型,这些模型可以在具有 6GB 以上显存的 GPU 上流畅运行,甚至可以在 CPU 模式下运行(虽然速度会较慢)。如果您的电脑没有独立显卡,我们提供了经过优化的 CPU 版本,可以在多核 CPU 上获得合理的性能。

FlashAI Qwen3 整合包是一个完全离线的安装包,包含了所有必要的模型文件和依赖库,安装过程不需要联网。这使得它特别适合在安全要求高、网络受限的环境中使用。但是,如果您希望获取最新的模型更新和功能改进,建议定期检查我们的官网获取更新。

FlashAI 整合包使用的是官方发布的 Qwen3 模型权重,但我们对模型进行了量化和优化,以提高在消费级硬件上的运行效率。此外,我们还提供了一个用户友好的图形界面,简化了模型的部署和使用过程,并添加了一些实用功能,如对话历史管理、提示词模板、文档分析等。

是的,FlashAI Qwen3 整合包可以用于商业项目,但请注意遵守 Qwen3 模型的使用许可条款。Qwen3 模型采用 Tongyi Qianwen License 许可协议,允许商业使用,但有一些限制条件。详细的许可信息可以在我们的官网或 Qwen 官方 GitHub 仓库中查看。